핵심 요약

- 가상 메모리는 물리 메모리의 한계를 극복하고 멀티태스킹을 가능하게 하는 운영체제의 핵심 기술입니다.

- 실제 주소 공간은 하드웨어 RAM 용량에 종속된 고정된 위치이며, 가상 주소 공간은 프로세스가 바라보는 논리적이고 연속적인 환상의 공간입니다.

- MMU와 페이징은 가상 주소를 물리 주소로 변환하는 통역사 역할을 하며, 시스템 안정성을 보장합니다.

- 64비트 환경에서는 주소 공간 부족 문제는 해결되었으나, 실제 물리 메모리 관리와 효율성은 여전히 중요합니다.

목차

- 서론 (Introduction)

- 본론 1: 하드웨어의 물리적 한계, 실제 주소 공간

- 본론 2: 운영체제의 환상, 가상 메모리와 주소 공간

- 본론 3: 핵심 매커니즘, 가상과 실제의 연결 (MMU & Paging)

- 본론 4: 2026년의 시스템 환경 (32bit vs 64bit)

- 본론 5: 왜 가상 메모리인가? (Benefits & Optimizations)

- 결론 (Conclusion)

- 자주 묻는 질문 (FAQ)

A. 서론 (Introduction)

가상 메모리와 실제 주소 공간 차이를 이해하는 것은 운영체제가 하드웨어의 물리적 한계를 어떻게 소프트웨어적으로 극복하는지 파악하는 핵심 열쇠입니다.

혹시 이런 궁금증을 가져본 적이 있으십니까? 내 컴퓨터의 물리 메모리(RAM)는 고작 16GB인데, 어떻게 설치 용량이 100GB가 넘는 최신 AAA급 오픈월드 게임이나 대용량 데이터베이스가 멈추지 않고 실행될 수 있을까요? 심지어 크롬 탭을 수십 개 띄워놓고도 음악을 듣고, 코딩을 하는 멀티태스킹이 어떻게 가능한 걸까요?

이 마법 같은 일의 배후에는 운영체제의 정교한 사기극(?)인 ‘가상 메모리’ 기술이 숨어 있습니다. 오늘은 물리적인 하드웨어인 ‘실제 주소’와 운영체제가 만들어낸 환상인 ‘가상 메모리’의 정의를 명확히 구분하고, 이 둘을 연결하는 MMU(Memory Management Unit)의 정교한 메커니즘을 해부해 보겠습니다. 2026년 현재 표준인 64비트 시스템 환경을 기준으로, 개발자라면 반드시 알아야 할 메모리 관리의 심연을 들여다봅니다.

B. 본론 1: 하드웨어의 물리적 한계, 실제 주소 공간

가상화 기술이 등장하기 전, 혹은 임베디드 시스템의 가장 기초적인 단계에서 CPU는 메모리에 직접 접근했습니다. 이때 사용되는 주소가 바로 실제 주소(Physical Address)입니다.

1. 실제 주소 공간 개념 (Physical Address Space Concept)

`실제 주소 공간 개념`은 매우 직관적이고 정직합니다. 이것은 컴퓨터 메인보드에 장착된 물리적 RAM의 용량에 의해 절대적인 크기가 결정됩니다.

- 하드웨어적 종속성: 만약 당신의 컴퓨터에 8GB RAM이 꽂혀 있다면, 실제 주소 공간은 0번지부터 약 85억 번지(2의 33승 근처)까지만 존재합니다.

- 고정된 위치: 이 주소는 하드웨어 제조 시점에 정해진 고정된 위치 값입니다. 0x0000…부터 시작하여 RAM의 끝까지 일직선으로 나열된 방들과 같습니다.

2. 물류 창고의 비유

이해를 돕기 위해 실제 주소 공간을 ‘물류 창고의 실제 선반 위치’로 비유해 보겠습니다.

- 창고(RAM)의 크기가 100평이라면, 물건을 놓을 수 있는 선반(주소)의 개수는 딱 100평 분량으로 제한됩니다.

- 선반이 꽉 차면(Out of Memory), 더 이상 어떤 물건(데이터)도 들여놓을 수 없습니다.

- 물건을 찾으려면 “A구역 3번 선반”처럼 정확한 물리적 위치를 알아야 합니다.

3. 부가 설명: 물리 주소의 한계와 메모리 버스

조금 더 깊이 들어가 볼까요? CPU가 메모리에 접근하려면 ‘주소 버스(Address Bus)’라는 전선을 통해 신호를 보냅니다. 실제 주소 공간의 최대 크기는 이 버스의 대역폭과 실제 장착된 RAM 칩의 용량 중 ‘더 작은 쪽’에 맞춰집니다. 과거에는 프로그래머가 이 실제 주소를 직접 코딩해야 했고, 다른 프로그램이 내 프로그램의 메모리 영역(선반)을 침범하여 데이터를 덮어쓰는 일이 비일비재했습니다. 즉, 실제 주소 공간만으로는 멀티태스킹 환경에서 안정성을 보장할 수 없다는 치명적인 단점이 존재합니다.

C. 본론 2: 운영체제의 환상, 가상 메모리와 주소 공간

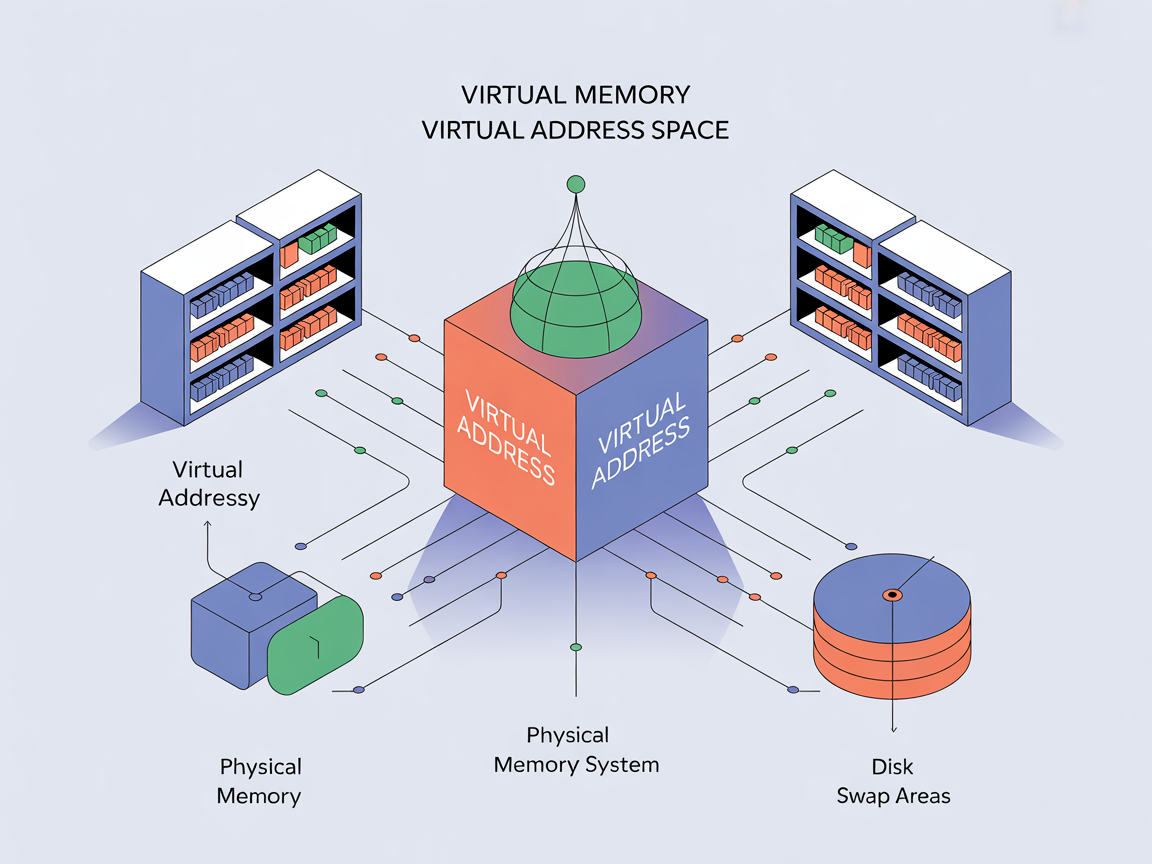

운영체제는 물리 메모리의 한계를 극복하기 위해 프로세스(실행 중인 프로그램)에게 거대한 환상을 심어줍니다. 이것이 바로 가상 메모리입니다. 여기서 중요한 점은 `가상 메모리 정의`와 가상 주소 공간을 명확히 구분해야 한다는 것입니다.

1. 개념의 분화: 가상 메모리 vs 가상 주소 공간

많은 분이 두 용어를 혼용하지만, 엄밀히 말하면 기술적 층위가 다릅니다.

- 가상 주소 공간 (Virtual Address Space): 프로세스가 생성될 때 운영체제로부터 할당받는 논리적인 주소 범위입니다. 모든 프로세스는 자신이 0번지부터 시작하는 독점적인 메모리 공간을 가지고 있다고 착각합니다.

- `가상 메모리 정의`: 물리 메모리(RAM)의 크기와 상관없이, 프로세스에게 “무한하고 연속적인 메모리 공간이 있다”고 믿게 만드는 운영체제의 메모리 관리 기술 전체를 의미합니다. 이는 RAM과 디스크(Swap 영역)를 묶어서 하나의 거대한 메모리처럼 보이게 만듭니다.

2. 택배 송장의 비유

앞선 창고 비유를 확장해 보겠습니다. 가상 주소는 ‘택배 송장에 적힌 배송지 주소’와 같습니다.

- 우리는 “서울시 강남구…”라는 주소(가상 주소)만 알면 됩니다.

- 실제로 그 물건이 창고의 “A-3 선반(물리 주소)”에 있는지, 아니면 잠시 “임시 야적장(스왑 영역)”에 있는지는 알 필요가 없습니다.

- 이 변환 과정은 물류 시스템(운영체제와 MMU)이 알아서 처리합니다.

3. 부가 설명: 프로세스의 착각과 격리

각 프로세스는 자신만의 가상 주소 공간(예: 0x0000 ~ 0xFFFF…)을 가집니다. A 프로그램의 100번지와 B 프로그램의 100번지는 가상 주소 상으로는 같지만, 실제 물리 메모리에서는 완전히 다른 위치(프레임)에 매핑됩니다. 이 덕분에 개발자는 다른 프로그램의 메모리 침범을 걱정할 필요 없이, 마치 컴퓨터 전체 메모리를 혼자 쓰는 것처럼 코드를 작성할 수 있습니다. 이것이 현대 OS가 안정적인 이유입니다.

D. 본론 3: 핵심 매커니즘, 가상과 실제의 연결 (MMU & Paging)

이제 가장 중요한 질문이 남았습니다. 어떻게 추상적인 ‘가상 주소’가 하드웨어의 ‘실제 주소’로 바뀌어 데이터를 읽고 쓸까요? 여기서 `가상 메모리와 실제 주소 공간 차이`를 기술적으로 연결하는 핵심 장치인 MMU가 등장합니다.

1. MMU (Memory Management Unit)의 역할

CPU는 오직 가상 주소만 바라보고 명령을 내립니다. 반면, 메모리는 실제 주소만 이해합니다. 이 둘 사이의 통역사가 바로 MMU입니다. MMU는 CPU 안에 내장된 하드웨어 회로로, 프로그램이 실행되는 도중 실시간으로 가상 주소를 물리 주소로 변환(Translation)합니다.

2. 페이징(Paging)과 페이지 테이블

이 변환 과정은 페이징(Paging)** 기법을 통해 효율적으로 관리됩니다.

- 페이지(Page): 가상 주소 공간을 일정한 크기(보통 4KB)로 자른 블록.

- 프레임(Frame): 물리 주소 공간(RAM)을 페이지와 동일한 크기로 자른 블록.

- 페이지 테이블(Page Table): 가상 페이지 번호(VPN)가 실제 물리 프레임 번호(PFN) 몇 번에 해당하는지 적혀 있는 매핑 테이블(지도).

[Diagram 1: 주소 변환 흐름 (Translation Flow)]

graph LR

A[CPU] -->|가상 주소 발생| B(MMU & TLB)

B -->|TLB Hit: 즉시 변환| C[물리 메모리]

B -->|TLB Miss: 페이지 테이블 참조| D{Page Table}

D -->|매핑 정보 확인| C

D -->|Page Fault: 데이터 없음| E[OS & Disk Swap]

style A fill:#f9f,stroke:#333

style C fill:#9f9,stroke:#333(위 다이어그램은 CPU가 가상 주소를 던지면 MMU가 이를 받아 물리 주소로 변환하여 RAM에 접근하는 과정을 보여줍니다.)

3. 세그먼테이션과의 차이

참고로, 메모리를 관리하는 또 다른 방법인 세그먼테이션(Segmentation)은 메모리를 의미 단위(Code, Data, Stack 등)로 가변적인 크기로 나눕니다. 하지만 현대의 운영체제는 외부 단편화 문제를 해결하기 위해 대부분 페이징 기법을 메인으로 사용하며, 세그먼테이션은 보안 등 보조적인 용도로 제한적으로 사용합니다.

4. 부가 설명: TLB의 중요성

매번 메모리의 페이지 테이블을 읽어서 주소를 변환하면 속도가 너무 느려집니다. 그래서 MMU 내부에는 TLB(Translation Lookaside Buffer)라는 초고속 캐시 메모리가 있습니다. “최근에 변환한 주소는 또 쓸 확률이 높다”는 원리를 이용해, TLB에 변환 정보를 저장해 둡니다. CPU는 먼저 TLB를 확인하고, 없을 때만(TLB Miss) 메모리의 페이지 테이블을 뒤집니다. 이 하드웨어적 최적화 덕분에 가상 메모리는 성능 저하를 최소화할 수 있습니다.

E. 본론 4: 2026년의 시스템 환경 (32bit vs 64bit)

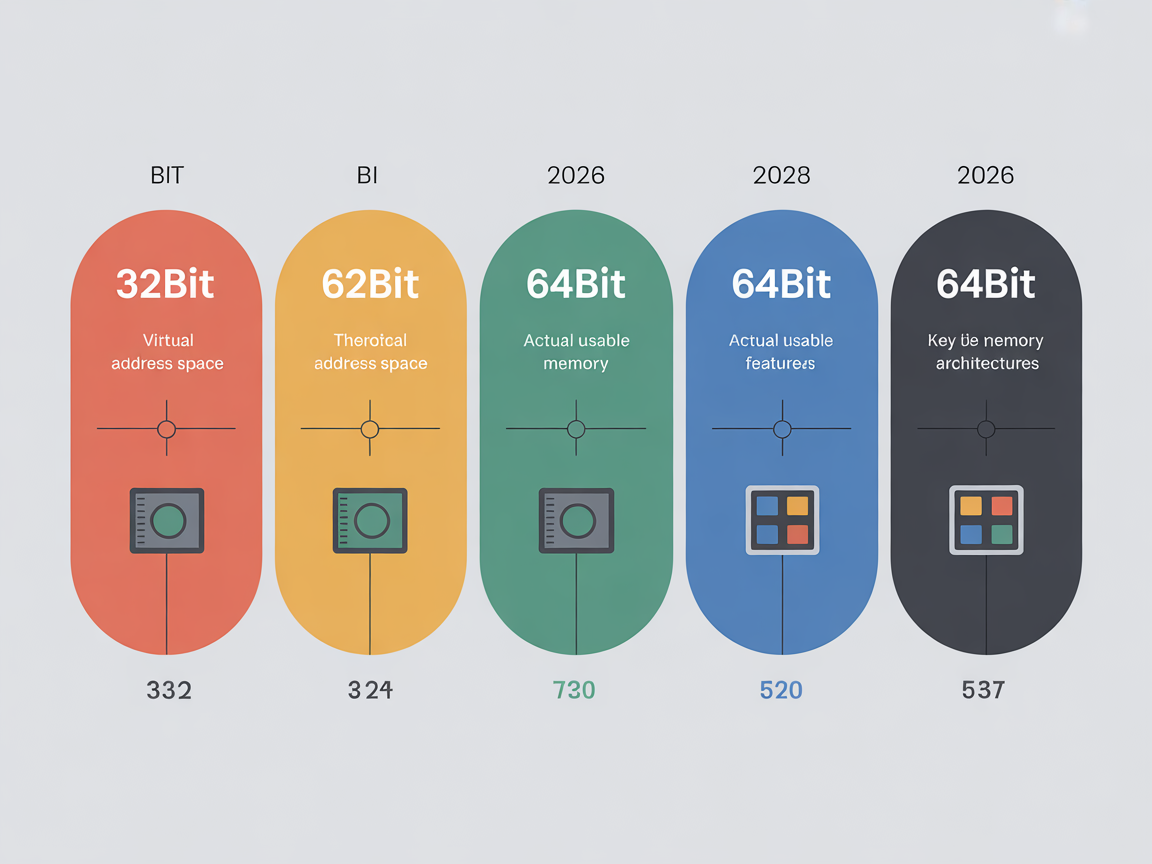

우리가 살고 있는 2026년 현재, 32비트 시스템은 거의 박물관으로 사라졌고 64비트가 표준이 되었습니다. 시스템 비트 수는 가상 주소 공간의 크기를 결정하는 결정적인 요소입니다.

1. 32비트와 64비트의 결정적 차이

| 시스템 아키텍처 | 가상 주소 공간 크기 (이론적) | 실제 활용 (Windows 기준) | 특징 |

|---|---|---|---|

| 32비트 | 2의 32승 = 4GB | 유저 영역 2GB / 커널 영역 2GB | 메모리가 4GB를 넘어도 OS가 인식 불가. 주소 공간 부족이 성능 병목의 원인. |

| 64비트 | 2의 64승 = 16 엑사바이트 | 유저 영역 128TB / 시스템 영역 128TB | 사실상 무한대에 가까운 주소 공간 제공. 주소 공간 부족 문제는 해결됨. |

2. 현대 개발 환경의 시사점

2026년의 64비트 환경에서 개발자들은 더 이상 “가상 주소 공간이 부족해서” 프로그램을 못 짜는 일은 없습니다. 128TB는 어마어마한 크기니까요. 하지만 주의할 점은, 가상 주소 공간이 넓어졌다고 해서 물리 메모리(RAM)가 늘어난 것은 아니라는 점입니다.

- 가상 주소는 펑펑 쓸 수 있지만, 이를 뒷받침할 실제 RAM(프레임)이 부족하면 시스템은 데이터를 디스크로 옮기는 스와핑(Swapping)을 반복하다가 느려집니다.

- 즉, 현대의 성능 이슈는 ‘주소 공간 부족’이 아니라 ‘물리 메모리 할당 효율성’에서 옵니다.

3. 부가 설명: Canonical Form Addresses

64비트 시스템이라고 해서 2의 64승개의 모든 주소를 다 쓰는 것은 아닙니다. 현재 하드웨어 구현의 효율성을 위해, 실제로는 48비트 또는 57비트(최신 Intel/AMD CPU) 정도만 주소 지정에 사용합니다. 나머지 비트는 모두 0이나 1로 채워진 특정 형태(Canonical Form)를 유지해야 합니다. 이는 하드웨어 복잡도를 줄이면서도 향후 메모리 확장을 대비한 설계입니다. 128TB라는 제한도 윈도우 OS 차원에서 설정한 제한일 뿐, 하드웨어는 더 발전하고 있습니다.

F. 본론 5: 왜 가상 메모리인가? (Benefits & Optimizations)

단순히 용량 뻥튀기를 넘어, 왜 현대 OS는 이 복잡한 가상 메모리 시스템을 고집할까요? 여기에는 성능과 보안을 위한 필수적인 최적화 기술이 포함되어 있습니다.

1. 메모리 보호 (Protection)

가상 메모리는 각 프로세스를 완벽하게 격리합니다. A 프로세스가 B 프로세스의 메모리 영역을 읽거나 쓰려고 하면, MMU는 즉시 하드웨어 인터럽트를 발생시켜 해당 접근을 차단하고 A 프로세스를 강제 종료(Segmentation Fault) 시킵니다. 이는 바이러스나 악성 코드가 시스템 전체를 장악하는 것을 막는 1차 방어선입니다.

2. 요구 페이징 (Demand Paging)

프로그램을 실행할 때, 실행 파일 전체(예: 50GB 게임)를 메모리에 다 올릴 필요가 없습니다.

- Lazy Loading: 2026년의 OS는 당장 실행에 필요한 페이지만 골라서 물리 메모리(RAM)에 올립니다.

- 나머지는 가상 주소 공간에만 존재하다가, 실제 접근이 일어날 때(Page Fault 발생 시) 디스크에서 가져옵니다. 이 덕분에 16GB RAM으로도 100GB 게임을 실행할 수 있습니다.

3. 메모리 공유 (Memory Sharing)

모든 C 프로그램이 사용하는 printf 같은 표준 라이브러리를 각 프로세스마다 메모리에 올린다면 낭비가 심할 것입니다.

- OS는 공유 라이브러리를 물리 메모리에 단 한 번만 로딩합니다.

- 그리고 여러 프로세스의 가상 주소 테이블이 동일한 물리 프레임(라이브러리 위치)을 가리키도록 매핑합니다. 이를 통해 엄청난 양의 RAM을 절약합니다.

4. 부가 설명: Copy-on-Write (COW)

유닉스 계열(Linux 등)에서 프로세스를 복제(fork())할 때, 처음에는 부모와 자식 프로세스가 같은 물리 메모리를 공유합니다(읽기 전용). 그러다 둘 중 하나가 데이터를 ‘쓰려고(Write)’ 할 때, 비로소 운영체제가 해당 페이지를 복사하여 분리합니다. 이 기법 덕분에 프로세스 생성 속도가 획기적으로 빨라지고 메모리 낭비가 줄어듭니다.

G. 결론 (Conclusion)

지금까지 `가상 메모리와 실제 주소 공간 차이`를 통해 8GB, 16GB 램으로도 거대한 프로그램을 돌릴 수 있는 원리를 살펴보았습니다.

핵심 요약: 가상 vs 실제

마지막으로 아래 비교표를 통해 두 개념을 정리해 보겠습니다.

| 비교 항목 | 가상 메모리 (Virtual Memory) | 실제 주소 공간 (Physical Address Space) |

|---|---|---|

| 정의 | 프로세스가 바라보는 논리적이고 연속적인 환상의 공간 | 하드웨어 상에 존재하는 물리적인 반도체 공간 |

| 주소 생성 주체 | CPU (프로그램 실행 시 생성) | 메모리 하드웨어 설계 시 결정 |

| 크기 결정 요인 | CPU 아키텍처 (64bit) 및 OS 설정 | 장착된 RAM의 실제 용량 (예: 16GB) |

| 특징 | 실제 메모리보다 훨씬 클 수 있음 (스왑 사용) | 물리적 용량을 초과할 수 없음 |

| 접근 방식 | MMU를 통해 물리 주소로 변환되어 접근 | 메모리 버스를 통해 직접 접근 |

개발자를 위한 조언

여러분은 이제 실제 주소 공간은 ‘물리적 창고’이고, 가상 메모리는 운영체제가 관리하는 ‘유연한 물류 시스템’이라는 것을 이해했습니다. 앞으로 Out of Memory(OOM) 오류를 마주하거나 고성능 애플리케이션을 최적화할 때, 단순히 “램을 더 사야 하나?”라고 고민하기보다 다음을 먼저 떠올려 보세요.

- 페이지 폴트(Page Fault)가 너무 잦지 않은가? (스레싱 현상 의심)

- 불필요하게 큰 가상 주소 공간을 잡아놓고 해제하지 않은 메모리 누수(Leak)는 없는가?

- 데이터 지역성(Locality)을 고려해 코드를 짰는가? (TLB 히트율 높이기)

`가상 메모리와 실제 주소 공간 차이`를 명확히 이해한 지금, 여러분은 하드웨어의 한계를 소프트웨어적으로 뛰어넘는 더 효율적이고 견고한 코드를 작성할 준비가 되셨습니다.

자주 묻는 질문 (FAQ)

Q: 가상 메모리와 가상 주소 공간의 차이는 무엇인가요?

A: 가상 주소 공간은 프로세스마다 할당되는 논리적인 주소 범위(예: 0~무한대)를 말하며, 가상 메모리는 이 공간을 물리 메모리 및 스왑 영역과 매핑하여 관리하는 전체적인 기술 시스템을 의미합니다.

Q: 64비트 시스템을 쓰면 메모리 부족 오류(OOM)가 절대 발생하지 않나요?

A: 아닙니다. 가상 주소 공간(방 번호)은 거의 무한하지만, 데이터를 실제로 저장할 물리 메모리(실제 방)가 부족하면 시스템이 느려지거나 OOM 오류가 발생할 수 있습니다.

Q: 페이지 폴트(Page Fault)가 발생하면 프로그램이 멈추나요?

A: 아닙니다. 페이지 폴트는 메모리에 없는 데이터를 디스크에서 가져오기 위한 정상적인 운영체제 매커니즘입니다. 다만, 이 현상이 지나치게 빈번하면 ‘스레싱’이 발생하여 시스템 속도가 급격히 저하될 수 있습니다.