핵심 요약

- 컴퓨터의 언어는 0과 1의 전기 신호이며, 이를 문자로 변환하기 위해 문자 집합과 인코딩이라는 약속이 필요합니다.

- ASCII는 최초의 표준이었으나 7비트의 한계로 인해 전 세계의 다양한 문자를 표현하기에는 부족했습니다.

- EUC-KR과 CP949의 혼재는 한글 깨짐 현상의 주원인이었으며, 이를 해결하기 위해 전 세계 문자를 통합한 유니코드가 탄생했습니다.

- UTF-8은 유니코드를 효율적으로 저장하는 웹 표준 인코딩 방식으로, 높은 호환성과 효율성을 자랑합니다.

목차

- 서론: 컴퓨터는 0과 1밖에 모른다

- 본론 1: 통신의 시작과 최초의 표준 (1960년대)

- 본론 2: 1바이트의 확장과 한국의 특수한 상황 (1980년대)

- 본론 3: 전 세계 문자의 통일, 유니코드 (1990년대 ~ 현재)

- 본론 4: 유니코드의 완성, UTF-8 (Technical Focus)

- 결론

- 자주 묻는 질문

서론: 컴퓨터는 0과 1밖에 모른다

웹페이지를 탐색하거나 오래된 텍스트 파일을 열었을 때, ‘믜믜’나 ‘???’처럼 알 수 없는 문자가 화면을 가득 채워 당황했던 경험이 있으신가요? 이러한 현상은 단순히 컴퓨터의 오류가 아니라, 텍스트를 주고받는 과정에서 서로의 약속(문자셋/인코딩 규칙)이 어긋나 발생한 ‘글자 깨짐(Mojibake)’ 현상입니다.

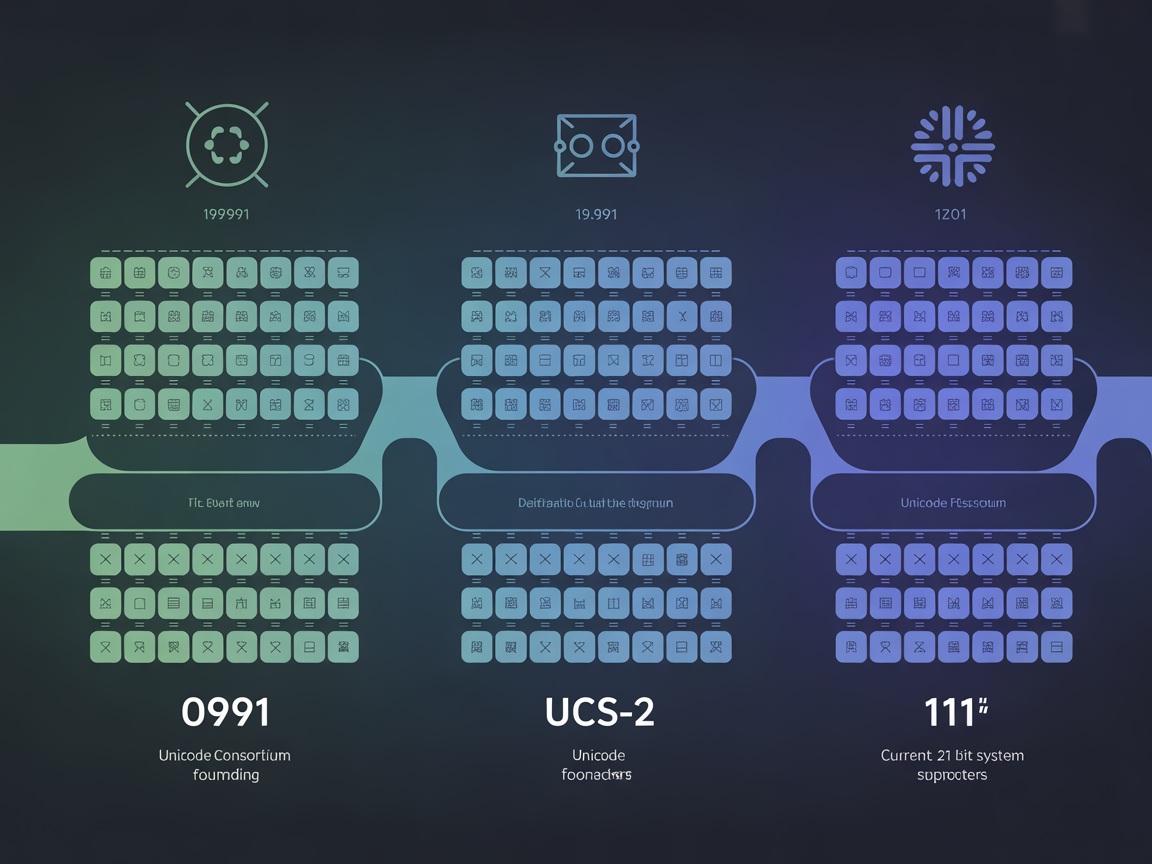

컴퓨터는 본질적으로 0과 1로 이루어진 전기 신호만 이해할 수 있습니다. 우리가 보는 ‘가’, ‘A’, ‘Smile’ 같은 문자를 컴퓨터가 처리하려면, 각 문자에 고유한 숫자를 부여하고 이를 다시 이진수로 변환해야 합니다. 이 과정에서 두 가지 핵심 개념이 등장합니다.

- 문자 집합(Character Set): “A는 65번, B는 66번”처럼 문자와 숫자를 1:1로 매핑한 ‘거대한 지도’입니다.

- 인코딩(Encoding): 지도상의 번호를 컴퓨터가 이해하는 0과 1의 전기 신호로 저장하는 ‘포장 규칙’입니다.

오늘 글에서는 복잡해 보이는 문자 집합 역사 정리를 통해, 우리가 매일 입력하는 텍스트가 어떤 원리로 화면에 표시되는지, 그리고 ASCII에서 유니코드에 이르는 기술적 진화 과정을 깊이 있게 알아봅니다.

본론 1: 통신의 시작과 최초의 표준 (1960년대)

최초의 표준, ASCII 코드의 탄생

1960년대 초반만 해도 컴퓨터 제조사들은 각자 제멋대로 문자를 숫자로 바꿨습니다. IBM 장비에서 작성한 문서를 다른 회사 컴퓨터로 가져가면 읽을 수 없는 호환성 지옥이 펼쳐졌습니다. 이 혼란을 정리하기 위해 1963년, 미국 표준 협회(ASA)는 ASCII(American Standard Code for Information Interchange)라는 표준을 발표했습니다.

이 ASCII 코드 역사는 현대 디지털 통신의 기반이 되었습니다. ASCII는 7비트 체계를 사용하여 총 128개(2^7)의 문자만 정의했습니다.

ASCII의 구성 요소:

- 0~31번: 제어 문자 (줄 바꿈, 탭, 벨 소리 등)

- 32~126번: 출력 가능한 문자 (영문 대소문자 52개, 숫자 10개, 특수 기호)

- 127번: 삭제(Delete) 문자

왜 8비트가 아닌 7비트였을까요? 당시에는 7비트 ASCII를 사용했고, 장비/통신 방식에 따라 남는 1비트를 데이터 전송 중 에러가 발생했는지 검사하는 패리티 비트(Parity Bit)로 사용하는 경우가 많았습니다. 예를 들어, 1의 개수를 짝수로 맞춰 전송하고, 수신 측에서 홀수가 발견되면 에러로 간주하는 방식입니다.

태생적 한계

ASCII는 영어권 국가인 미국에서는 완벽했습니다. 하지만 128개의 공간으로는 프랑스어의 악센트(é), 독일어의 움라우트(ü), 그리고 수천 자에 달하는 한자나 한글을 담을 수 없었습니다. 컴퓨터가 전 세계로 보급되면서, 이 작은 ‘지도’는 곧 한계에 봉착합니다.

본론 2: 1바이트의 확장과 한국의 특수한 상황 (1980년대)

확장 아스키(Extended ASCII)와 코드 페이지의 혼란

1980년대 PC가 대중화되면서, 통신 기술이 발전해 더 이상 패리티 비트가 필수적이지 않게 되었습니다. 개발자들은 남는 1비트를 활용해 표현 범위를 8비트(256자)로 늘렸습니다. 이를 ‘확장 아스키(Extended ASCII)’라고 부르기도 하는데, 사실은 여러 8비트 확장/코드 페이지 변형을 통칭하는 말에 가깝습니다.

하지만 256자도 전 세계 문자를 담기엔 턱없이 부족했습니다. 그래서 등장한 해결책이 ‘코드 페이지(Code Page)’입니다. 0~127번은 ASCII와 똑같이 유지하되, 확장된 128~255번 영역을 국가별로 다르게 정의해 사용하는 방식입니다.

코드 페이지의 문제점:

| 코드 페이지 | 0xC4 (196번) | 설명 |

|---|---|---|

| CP437 (미국) | ─ | 가로 선 그리기 문자 |

| CP850 (서유럽) | Ä | 독일어 대문자 A 움라우트 |

같은 파일이라도 미국 PC에서 열면 선으로 보이고, 독일 PC에서 열면 ‘Ä’로 보이는 문제가 발생했습니다. 이것이 바로 초기 ‘글자 깨짐’의 주된 원인이었습니다.

한국의 인코딩 전쟁: EUC-KR vs CP949

한글은 자음과 모음의 조합으로 만들어지는 문자로, 경우의 수가 11,172자에 달합니다. 1바이트(256자)로는 도저히 표현할 수 없어 2바이트(Multi-byte) 방식이 도입되었습니다.

- EUC-KR (완성형 표준):

- 1987년 제정된 국가 표준입니다.

- 자주 쓰는 한글 2,350자만 추려내어 코드표에 넣었습니다.

- 문제점: ‘똠’, ‘펲’ 처럼 표에 없는 글자는 입력조차 할 수 없었습니다. 드라마 제목 ‘똠방각하’를 컴퓨터에 칠 수 없어 ‘돔방각하’로 적어야 했던 웃지 못할 해프닝이 있었습니다.

- CP949 (확장 완성형):

- 마이크로소프트가 윈도우 95를 출시하며 도입했습니다.

- EUC-KR이 비워둔 공간에 나머지 한글 8,822자를 억지로 채워 넣었습니다.

- 결과: 모든 현대 한글 11,172자를 표현할 수 있게 되었지만, 한글 가나다순 정렬이 뒤죽박죽이 되는 부작용을 낳았습니다.

본론 3: 전 세계 문자의 통일, 유니코드 (1990년대 ~ 현재)

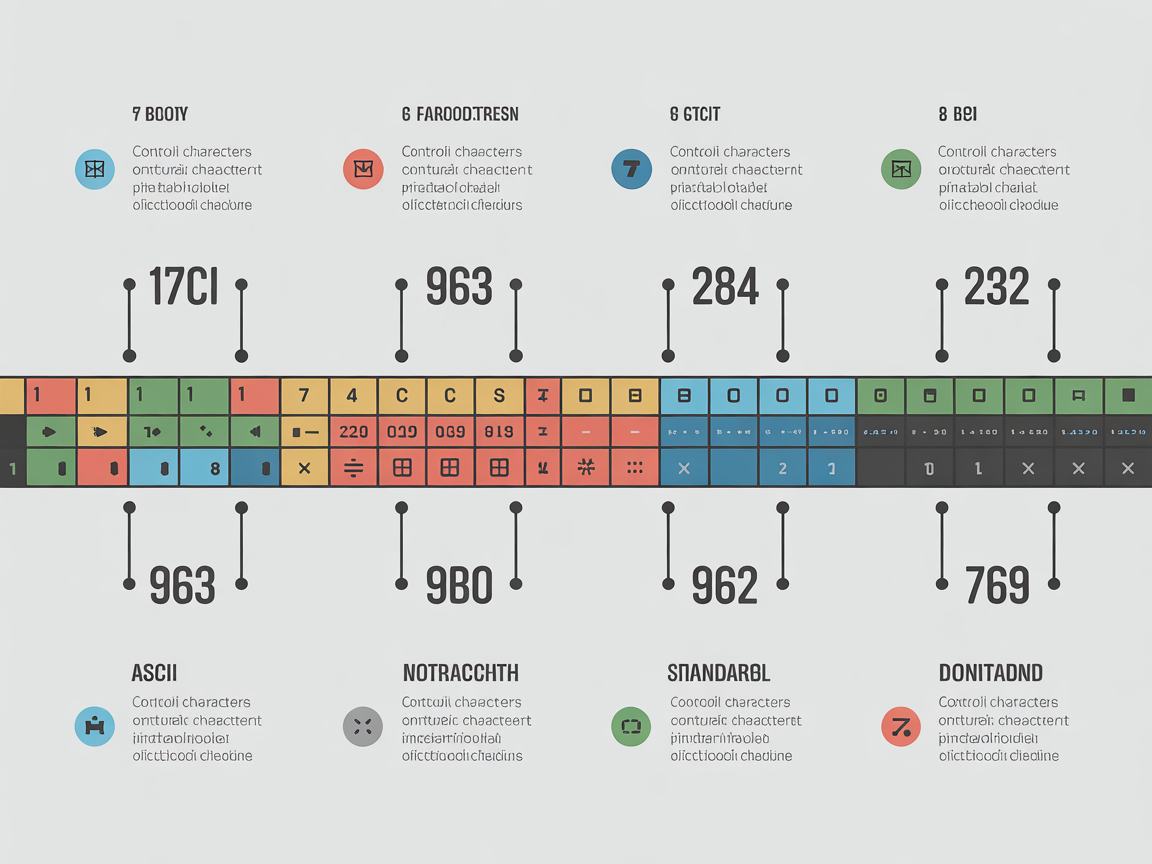

유니코드의 탄생과 유니코드 발전 과정

인터넷의 등장으로 국경 없는 데이터 교환이 폭발했습니다. 더 이상 수백 개의 코드 페이지를 바꿔가며 통신할 수 없게 되자, 전 세계 모든 문자를 하나의 거대한 표에 담자는 원대한 프로젝트가 시작되었습니다. 1991년, 유니코드 컨소시엄이 설립되고 Unicode 1.0이 발표되었습니다.

유니코드 발전 과정은 끊임없는 확장의 역사입니다.

- 초기 (UCS-2): 모든 문자를 2바이트(65,536자) 안에 담으려 했습니다. 하지만 고대 문자, 이모지, 희귀 한자 등이 추가되면서 공간이 부족해졌습니다.

- 현재: 21비트 체계로 확장되어 약 111만 자(U+10FFFF)까지 수용할 수 있게 되었습니다.

유니코드의 구조: 평면(Plane)

유니코드는 0번부터 111만 번까지 번호를 매기는데, 이를 65,536개씩 묶어 ‘평면(Plane)’이라고 부릅니다.

- BMP (기본 다국어 평면): 0번 ~ 65,535번. 한글, 한자, 영문 등 전 세계 현대 문자의 대부분이 여기에 속합니다. (예: ‘가’ =

U+AC00) - SMP (보조 다국어 평면): 이모지, 고대 상형 문자, 음악 기호 등이 포함됩니다.

이제 “한국어 윈도우에서 작성한 문서를 프랑스어 윈도우에서 열어도 깨지지 않는” 세상이 열린 것입니다.

본론 4: 유니코드의 완성, UTF-8 (Technical Focus)

문자 집합 vs 인코딩 방식

많은 분이 혼동하는 부분입니다. 유니코드는 문자에 번호를 붙인 ‘추상적인 약속’일 뿐, 파일로 저장하는 방법은 아닙니다. 유니코드 번호를 실제 컴퓨터 파일로 저장하는

기술(인코딩)에는 UTF-8, UTF-16, UTF-32 등이 있습니다.

UTF-8이 표준이 된 이유

2026년 현재, 전 세계 웹사이트의 약 99%가 UTF-8을 사용합니다. 왜 UTF-8이 최후의 승자가 되었을까요?

- 가변 길이 (효율성):

- 자주 쓰는 영문/숫자는 1바이트로 저장합니다.

- 한글이나 한자는 3바이트, 이모지는 4바이트를 사용합니다.

- 영어 문서의 경우 파일 크기가 획기적으로 줄어듭니다.

- 하위 호환성 (Killer Feature):

- UTF-8의 1바이트 영역은 ASCII 코드와 100% 동일합니다.

- 수십 년 전에 만들어진 ASCII 기반 시스템이나 프로그램이 아무런 수정 없이 UTF-8 파일을 읽을 수 있습니다. 이것이 UTF-8이 웹을 지배하게 된 결정적인 이유입니다.

인코딩 방식 비교:

| 방식 | 한글(‘가’) 크기 | 영문(‘A’) 크기 | 특징 |

|---|---|---|---|

| UTF-8 | 3 Byte | 1 Byte | 웹 표준, 용량 효율적, ASCII 호환 |

| UTF-16 | 2 Byte | 2 Byte | 윈도우, 자바 내부 처리용 |

| UTF-32 | 4 Byte | 4 Byte | 모든 문자가 고정 길이, 용량 낭비 심함 |

개발자를 위한 마지막 팁: 데이터베이스, HTML 헤더, 소스 코드 저장 시 무조건 UTF-8을 사용하세요. 이것 하나만 지켜도 인코딩으로 인한

스트레스의 99%는 사라집니다.

<meta charset="UTF-8">결론

문자 집합 역사 정리는 곧 인류가 디지털 바벨탑을 쌓아 올린 역사입니다. 1960년대 128자의 작은 ASCII 표에서 시작해, 국가 간 장벽을 넘기 위한 코드 페이지의 혼란을 겪고, 마침내 전 세계 14만 자 이상의 문자를 아우르는 유니코드로 통합되었습니다.

우리가 친구에게 보내는 선글라스 낀 이모지 하나에도 U+1F60E라는 전 세계 공통의 약속이 숨어 있습니다. 기술이 언어의 장벽을 허물고, 소통의 도구를 통일해온 과정이 바로 인코딩의

발전사입니다. “한글이 깨지면 무조건 UTF-8 설정부터 확인한다”, 이것이 글로벌 표준 시대의 생존 법칙입니다.

자주 묻는 질문

Q: ASCII 코드만 사용하면 안 되나요?

A: 영문만 사용한다면 가능하지만, 한글이나 이모지 등 다양한 문자를 표현할 수 없어 현대 웹 환경에서는 부적합합니다.

Q: 텍스트 파일이 ‘믜믜’처럼 깨지는 이유는 무엇인가요?

A: 파일을 저장할 때 사용한 인코딩 방식(예: EUC-KR)과 파일을 열 때 사용한 방식(예: UTF-8)이 일치하지 않기 때문입니다.

Q: UTF-8과 UTF-16 중 무엇이 더 좋은가요?

A: 웹 환경과 호환성 측면에서는 UTF-8이 압도적으로 유리하며 표준으로 사용됩니다. UTF-16은 특정 OS 내부 처리 등 제한적인 환경에서 쓰입니다.